¿La inteligencia artificial está lista para tomar decisiones morales?

Cada vez más, los sistemas computacionales, entre ellos los robots y las inteligencias artificiales (IA), tienen mayor presencia en la sociedad. Lo queramos o no, también habrá cada vez más situaciones en las que deban tomar decisiones morales con efectos importantes, como es el caso de los vehículos autónomos. ¿Cómo los entrenaremos para que tomen las mejores decisiones? ¿Estas decisiones podrán llegar a ser incluso mejores que las nuestras?

Si quieres saber más sobre la moral de los sistemas informáticos a la hora de tomar decisiones, no te pierdas la conferencia magistral The Moral Machine Experiment del Dr. Edmond Awad, investigador de la Universidad de Oxford, el próximo 31 de agosto, durante el Foro Construyendo el futuro de la inteligencia artificial, que tiene lugar en nuestra IBERO esta semana. ¿Ya te registraste para asistir a conferencias y talleres con ponentes internacionales? ¡Es gratuito!

The Moral Machine Experiment, ¿es fácil distinguir el mal menor?

Un antiguo dilema muy conocido en los campos de la filosofía moral, el derecho y la ética es el Problema del Tranvía. En este planteamiento, una persona tiene la oportunidad de cambiar la vía sobre la que viene un tranvía sin control. Si no se hace ningún cambio, el tranvía va a atropellar a cinco personas que están en la vía; si se hace el cambio, va a atropellar a una persona en la otra vía. No hay más opciones y hay que tomar una decisión de vida o muerte.

Por supuesto que las decisiones de la vida diaria no son siempre tan simples y no es tan fácil distinguir cuál es el “mal menor”. Como seres humanos, solemos tomar en cuenta muchísimos factores para tomar las decisiones más acertadas de acuerdo con el contexto en un panorama amplio.

Para estudiar cómo es que las personas tomamos decisiones éticas y qué factores tomamos en cuenta para hacerlo, el Dr. Edmond Awad y sus colegas han diseñado, desde el campo de la informática y las ciencias de la computación, el Experimento de la Máquina Moral, o The Moral Machine Experiment, basado en el filosófico Problema del Tranvía.

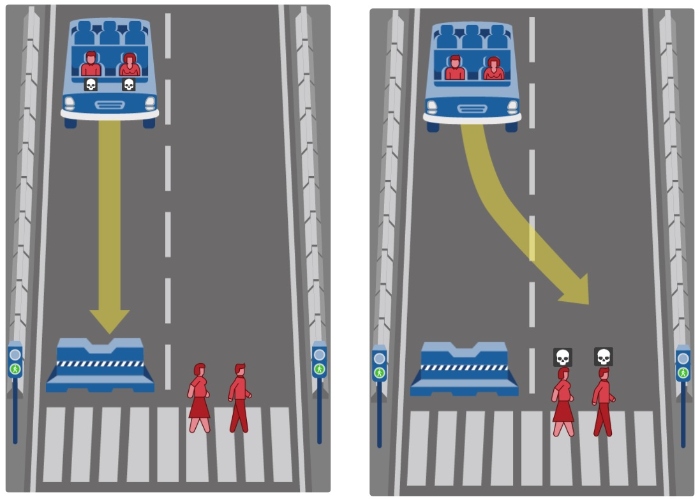

En este caso, actualizado al siglo XXI, se trata de un coche autónomo (como los que ya circulan en San Francisco, en Estados Unidos). En la situación hipotética del experimento, el vehículo se queda sin frenos y debe decidir entre seguir avanzando o girar y estrellarse. Si avanza, atropellará a cierto número de peatones que perderán la vida; si gira, morirán los pasajeros. De hecho, se trata de varios escenarios: con mujeres, hombres, niños, niñas, animales, profesionistas, personas en situación de calle, adultos y adultas mayores, personas con obesidad o deportistas.

Las y los investigadores han recolectado más de 40 millones de decisiones éticas y han descubierto tres constantes de lo que la gente considera el mal menor: la preferencia de perdonar a los humanos sobre las mascotas, la preferencia de perdonar a más personajes en lugar de menos personajes y la preferencia de perdonar a los humanos más jóvenes sobre los humanos mayores. ¿Quieres poner a prueba tus propios criterios? ¡Haz la prueba en su sitio web!

Aunque la toma de decisiones morales humanas puede no ser ideal, dicen las y los expertos que crearon este experimento, un camino hacia la fabricación de máquinas moralmente competentes puede comenzar por traducir al lenguaje de las computadoras la toma de decisiones morales humanas con planes de mejorarla.

¿Qué podemos esperar de las decisiones actuales de las máquinas?

Los resultados del Experimento de la Máquina Moral pueden tardar en ser aplicados, por lo que consultamos con el Mtro. Andrés Tortolero Baena, Coordinador de la Ingeniería en Ciencia de Datos de la Universidad Iberoamericana, cuál es el panorama actual de la toma de decisiones de los sistemas computacionales, entre ellos los robots y las inteligencias artificiales.

En el caso de la inteligencia artificial, explica el académico, se toma muchísima información para entrenar a todos estos sistemas, que es en lo que se van a basar para tomar decisiones. “Si no es una información correcta o si es una información deficiente, o si es poca información, el panorama que va a tener para tomar una decisión está limitado”.

Es cierto que las decisiones de las personas tampoco pueden ser siempre las correctas, admite el Mtro. Tortolero Baena, pero las personas se basan en algo más que sólo información para tomar decisiones; “se basan en un entorno, en un contexto, en percepciones que se van adquiriendo a lo largo de los años con base en la experiencia de las personas. Y aunque la inteligencia artificial adquiere conocimiento con base en la experiencia, no es la experiencia de algo vivido, sino algo aprendido, que se basa en la información que se le dé”.

El académico considera que las decisiones que puedan tomar las IA tienen que estar acompañadas por un monitoreo humano, porque se trata de decisiones totalmente cerradas. “Sería el equivalente de una persona cerrada, con poco criterio, y que no ve otra cosa más que su propia visión”. Podría servir como ayuda o herramienta para tomar decisiones, pero no podría, por lo menos actualmente, ser la decisión final que se lleve a cabo, dice el Mtro. Tortolero. En ese sentido, una IA puede ayudar a abrir el panorama de una persona desde otro punto de vista, o para considerar alguna otra situación o algún otro criterio adicionales, que ayude a la persona a “pensar fuera de la caja”.

Finalmente, considera que aunque esta tecnología ciertamente ha avanzado bastante en muy poco tiempo, todavía le falta mucho para poder ser algo en lo que podamos confiar 100% “y encomendarle nuestra vida”. ¿Tú qué opinas? ¿Crees que la tecnología es confiable en éste y otros ámbitos?

|

En medio de esta y otras polémicas, del 29 al 31 de agosto la IBERO será sede del foro ‘Construyendo el Futuro de la Inteligencia Artificial’, en el cual especialistas de distintos países, representantes de la academia, estudiantes, instituciones e industria, dialogarán en nuestra Universidad sobre el estado actual de esta tecnología en desarrollo. El objetivo es analizar el papel crucial que desempeñan las universidades en el diseño e implementación de soluciones a problemas complejos con estos nuevos recursos. |

Texto: Yazmín Mendoza

Notas relacionadas:

- Construyendo el futuro de la inteligencia artificial: Foro internacional en la IBERO

- ¿Qué es la Inteligencia Artificial y cómo permea en nuestra vida cotidiana?

- ¿Cómo hacer que la IA sea herramienta de aprendizaje y no obstáculo?

- ¿Inteligencia Artificial y Arquitectura? Académica nos da tips para usar Midjourney

- Doce criterios a seguir para un desarrollo ético de la Inteligencia Artificial

|

En medio de esta y otras polémicas, del 29 al 31 de agosto la IBERO será sede del foro ‘Construyendo el Futuro de la Inteligencia Artificial’, en el cual especialistas de distintos países, representantes de la academia, estudiantes, instituciones e industria, dialogarán en nuestra Universidad sobre el estado actual de esta tecnología en desarrollo. El objetivo es analizar el papel crucial que desempeñan las universidades en el diseño e implementación de soluciones a problemas complejos con estos nuevos recursos. |

Las opiniones y puntos de vista vertidos en este comunicado son de exclusiva responsabilidad de quienes los emiten

y no representan necesariamente el pensamiento ni la línea editorial de la Universidad Iberoamericana.

Para mayor información sobre este comunicado llamar a los teléfonos: (55) 59 50 40 00, Ext. 7594, 7759

Comunicación Institucional de la Universidad Iberoamericana Ciudad de México

Prol. Paseo de la Reforma 880, edificio F, 1er piso, Col. Lomas de Santa Fe, C.P. 01219